Microsoft vient de lever le voile sur une innovation de rupture dans le domaine de l'intelligence artificielle : VASA-1, une technologie capable de créer des avatars humains d'un réalisme troublant. Le calendrier de disponibilité de cette technologie reste flou. Ce qui suscite des inquiétudes quant à son utilisation malveillante en période électorale.

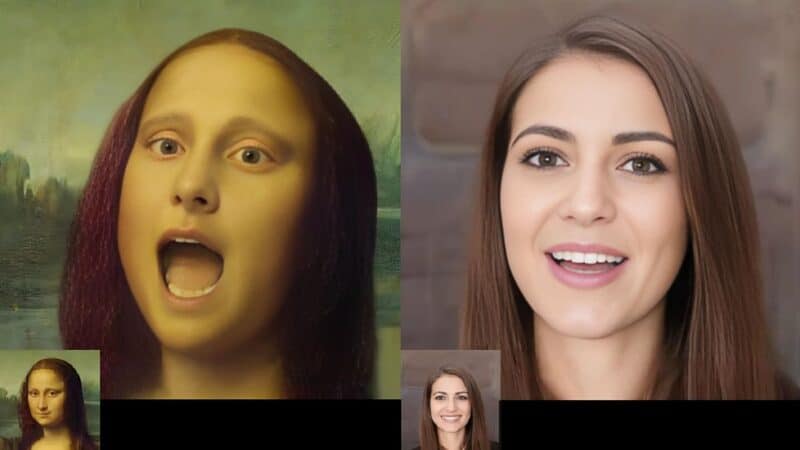

VASA-1, abréviation de « Visual Affective Skills », est le dernier né des laboratoires de Microsoft. Cette intelligence artificielle peut générer une vidéo animée d'une personne en train de parler. Elle synchronise les mouvements des lèvres à partir d'une simple photo et d'un enregistrement vocal. Le potentiel est immense, de l'enseignement virtuel au soutien thérapeutique.

Les craintes de la désinformation avec l'IA

Les experts en désinformation sonnent l'alarme, car l'abus potentiel de ces applications IA pourrait être dévastateur, notamment en période électorale. Microsoft, consciente de ces enjeux, prend des mesures strictes. « Nous sommes opposés à toute utilisation de notre technologie pour créer du contenu trompeur ou nuisible« , affirment les chercheurs.

Éthique et régulation des technologies IA chez Microsoft

Microsoft insiste sur son engagement envers un développement responsable de l'IA. Aucune démo en ligne, API ou détail d'implémentation supplémentaire ne sera publié tant que la responsabilité d'utilisation ne sera pas garantie. La technologie, bien que prometteuse, est encore marquée par des « artefacts » révélant sa nature générée par IA.

Potentiel et précautions

Outre les avatars pour réunions Zoom, comme envisagé par Ben Werdmuller de ProPublica, VASA pourrait transformer l'éducation et le soutien psychologique grâce à des avatars virtuels engageants. Néanmoins, le spectre du mésusage reste prégnant, surtout avec les progrès récents d'autres outils IA comme le « Voice Engine » d'OpenAI.

D'autres cas de mésusage de l'IA

L'utilisation abusive de l'IA est déjà une réalité. Plus tôt cette année, on a eu une imitation de la voix de Joe Biden dans un appel robotisé. Cela démontre les dangers potentiels de ces technologies. Ce cas illustre les défis éthiques et sécuritaires auxquels les développeurs d'IA doivent faire face.

Alors que Microsoft forge l'avenir avec des avatars ultraréalistes, la balance entre innovation et éthique reste fragile. La promesse de VASA-1 est indéniable. Mais sa mise en œuvre doit être scrupuleusement encadrée pour éviter tout dérapage. L'avenir dira si les bénéfices l'emporteront sur les risques associés à ces technologies de pointe.

- Partager l'article :